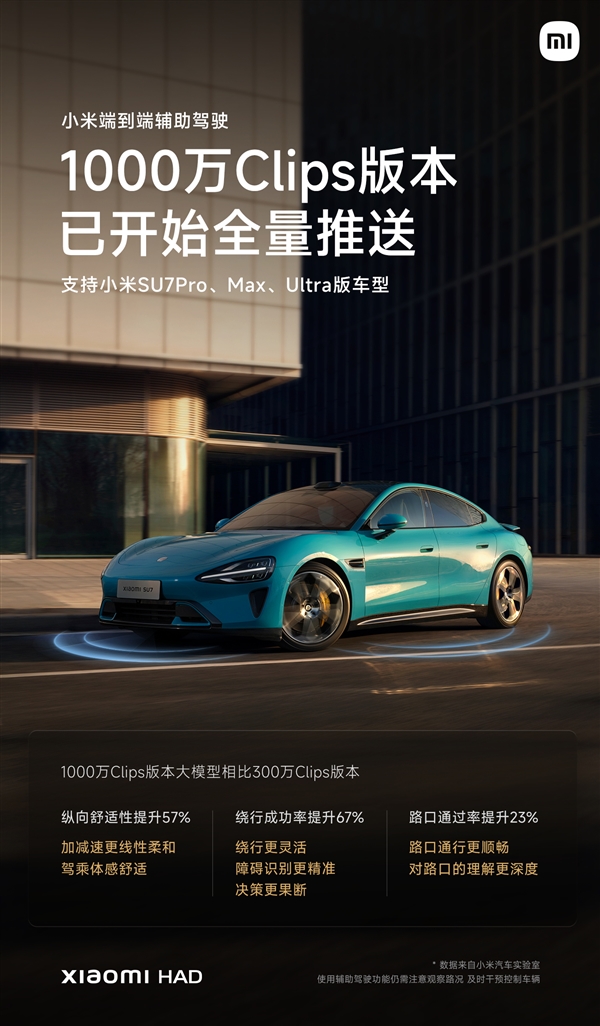

7月29日,快科技报道,小米汽车正式发布,其1000万Clips版本端到端辅助驾驶系统(YU7系列车型出厂即配备),目前已开始向小米SU7系列用户推送更新,该系统兼容小米SU7 Pro、Max和Ultra等车型。

小米汽车公司宣布,作为业界率先实现1000万Clips版端到端辅助驾驶量产的企业,其最新推出的1000万Clips版小米端到端辅助驾驶系统在细节体验上实现了全面升级,与之前推出的300万Clips版本相比,具体表现在:

纵向空间体验提升了57%,操控加减速过程更加平顺,即便在交通拥堵频繁启停的情况下,乘客也不易感到晕车。

绕行成功率显著增长至67%,决策迅速且果断,路线规划精确无误,即便在狭窄的道路环境中,面对占道停车或会车需求,也能轻松应对。

路口通行效率提高了23%,对国内路口的运作机制有了更深的认识,即便是在人车混流的城中村和老街区,也能顺畅通行。

同时,小米端到端辅助驾驶的1000万Clips版本在高速行驶环境中实现了显著改进,升级后的高速领航辅助系统运行更为稳定,乘坐体验也更加舒适。

Clips究竟是什么?简而言之,它是指那些记录了驾驶过程片段的视频,这些片段中融合了由激光雷达、摄像头、毫米波雷达等不同传感器同步采集的多模态信息,其时长通常介于30秒到1分钟之间。

Clips有何作用?众所周知,端到端的大规模模型乃是一种依托数据驱动的辅助驾驶技术体系。所谓数据驱动,即指该模型通过学习既有的驾驶行为,提取出相应的驾驶策略。因此,它对大规模的数据训练有着极高的依赖性,而Clips正是这种端到端大模型的训练资料。

若将未经过训练的端到端大型模型比作一个刚刚报名驾校的新手司机,那么Clips便如同其在学习驾驶过程中积累的实战经验,所接触的系统学习场景越多,累积的经验就越丰富,等级也就越提升,其驾驶技能自然也就愈发娴熟。

概括而言,当Clips数量累积至千万级别,端到端大模型操控车辆将更为顺畅自然,乘客体验将愈发接近经验丰富的驾驶员。

1000万Clips,顾名思义,就是由一千万个视频片段组成。这样的端到端大模型经过对大量素材的反复训练,能够提炼出丰富的驾驶策略,使得系统能够自如地应对道路上的各种复杂情况。

然而,仅仅依靠大量做题的战术往往会导致效率低下,这好比让备战高考的学生日复一日地反复练习100以内的加减法,即便练习得再多,恐怕也难以实现进入理想大学的愿望。

1000万Clips旨在为端到端大模型提供充足且实用的训练数据,这些数据不仅涵盖了城市道路、高速公路等交通秩序井然的常见情景,还囊括了尽可能多的复杂场景,同时确保在这些复杂场景中驾驶行为既安全又舒适。

小米汽车强调,目前辅助驾驶技术尚不属于完全自动驾驶,恳请用户朋友们准确把握并合理运用辅助驾驶的各项功能,务必在紧急情况下能够有效操控车辆。